Adversarial Vulnerabilities (敵対的脆弱性)

最新項目へ

ニューラルネットワークの興味深い特性 (2013)

(Intriguing properties of neural networks)

ディープニューラルネットワーク(DNN)に、人間には知覚できないほどのわずかな摂動(ノイズ)を加えることで、モデルが誤分類を引き起こす「Adversarial Example(敵対的サンプル)」が存在することを初めて体系的に示した論文。

論文はこちら

敵対的サンプルの解明と活用 (2014)

(Explaining and Harnessing Adversarial Examples)

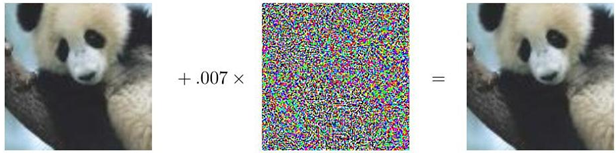

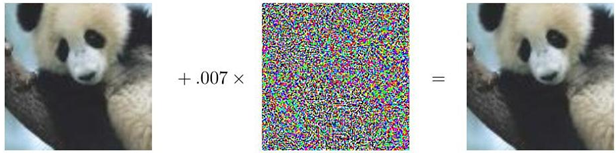

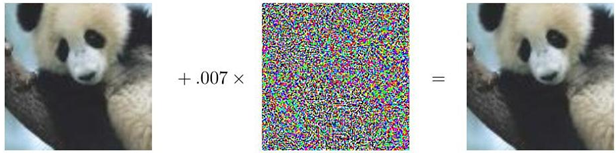

最先端のモデルが知覚できない摂動によって体系的に騙されることを実証することで、安全性に重要なアプリケーションに展開されているAIシステムにおける重大な脆弱性を浮き彫りにした。

(左) 確信度57.7%でパンダと認識される画像

(中) 知覚できない程度のノイズ

(右) (左)+0.07×(中)。99.7%の確信度でテナガザルと認識される

(左) 確信度57.7%でパンダと認識される画像

(中) 知覚できない程度のノイズ

(右) (左)+0.07×(中)。99.7%の確信度でテナガザルと認識される

論文はこちら

要約はこちら

機械学習モデルに対するメンバーシップ推論攻撃 (2016)

(Membership inference attacks against machine learning models)

攻撃者が特定の例が訓練セットに含まれていたかどうかを判断する、密接に関連した問題であるメンバーシップ推論攻撃に関する基礎的な研究。

論文はこちら

要約はこちら

秘密の共有者:ニューラルネットワークにおける意図せざる記憶の評価と検証 (2018)

(The secret sharer: Evaluating and testing unintended memorization in neural networks)

「カナリア」挿入を用いてニューラルネットワークから学習データを抽出する概念を確立。

論文はこちら

要約はこちら

大規模言語モデルからの学習データ抽出 (2020)

(Extracting training data from large language models)

この画期的な研究は、大規模言語モデルからの学習データ抽出における具体的なリスクを実証し、プライバシーの脆弱性に対する重要な証拠を提供した。

論文はこちら

要約はこちら

トップに戻る